知识蒸馏(Knowledge Distillation)的核心技术细节

之前部署模型遇见模型太大、速度太慢时,我的解决方案一般是选择训练小模型。在做小模型选型时先判断好内存占用和推理耗时,然后优化小模型的精度。当时觉得知识蒸馏和模型裁剪的效果完全不如重新训练小模型。不过近期 LLM(大语言模型)基本都是一个原始版上百 B 的参数,然后蒸馏很多 0.5B、1B、2B、7B 等不同参数量的小模型。最近遇见需要部署一个内存占用约 500M 的模型到手机上,直接部署后甲方反馈速度慢、app 太大。后面想到使用 Distillation 来解决,此文对知识蒸馏中的概念和原理进行整理。

```

<div class="stickywrap"><div>

<?php while ( have_posts() ): the_post(); ?>

<?php

// Assign the year to a variable

$year = get_the_date('Y', '', '', FALSE);

$year_link = get_year_link($year);

// If your year hasn't been echoed earlier in the loop, echo it now

if (! isset($year_check) || $year !== $year_check) {

echo "</div></div><div class='stickywrap'><h3 class='stickywrap-heading'><a href='" . $year_link . "'>" . $year . "</a></h3><div class='stickywrap-inner'>";

}

// Now that your year has been printed, assign it to the $year_check variable

$year_check = $year;

?>

<?php get_template_part('content'); ?>

<?php endwhile; ?>

</div></div>

```

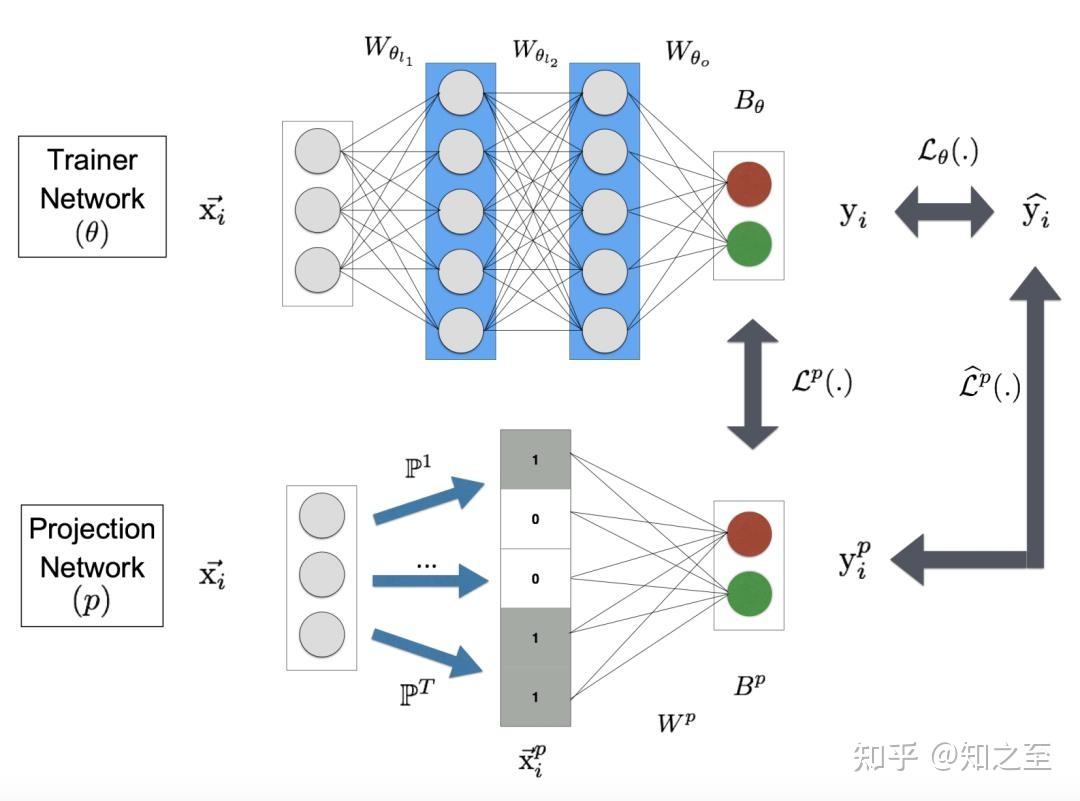

知识蒸馏(Knowledge Distillation,简称 KD)是一种模型压缩与知识迁移技术,其核心思想是将训练成熟的复杂模型(称为“教师模型”)所蕴含的知识迁移到结构更简洁、计算效率更高的模型(称为“学生模型”)中。这种技术在保持模型性能接近教师模型的同时,显著降低了模型的参数量和推理时间,因此在边缘计算、移动设备部署等场景中还是很有重要应用价值。本文将深入解析知识蒸馏的技术细节,包括核心原理、关键参数、损失函数设计、常见方法及应用场景。

最近遇见需要部署一个内存占用约 500M 的模型到手机上,直接部署后甲方反馈速度慢、app 太大。后面想到使用 Distillation 来解决,此文对知识蒸馏中的概念和原理进行整理。